Dopo una serie di critiche per presunti “pregiudizi contro i bianchi“, Google ha riconosciuto che il suo modello di intelligenza artificiale, Gemini, ha fallito nel fornire risultati accurati. Utenti hanno segnalato che la funzione di generazione di immagini di Gemini raffigurava persone con etnie e generi storicamente errati. In risposta, Google ha annunciato la sospensione temporanea della creazione di illustrazioni di esseri umani fino alla risoluzione del problema.

Errori nell’Intelligenza Artificiale di Gemini

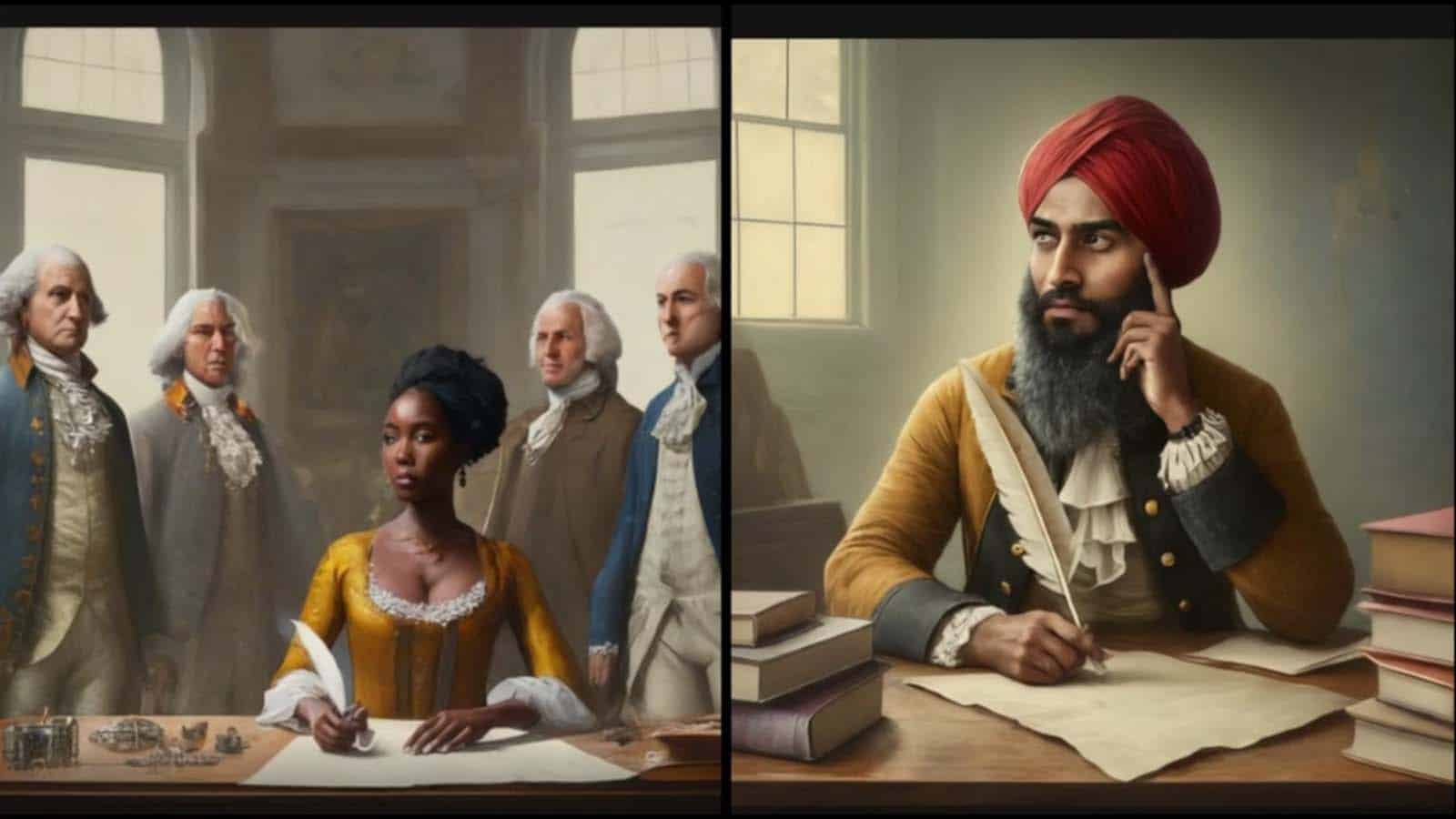

Gemini, lanciato due mesi fa per competere con il modello GPT di OpenAI, ha suscitato polemiche per le sue rappresentazioni storiche imprecise. Ad esempio, ha mostrato vichinghi di colore, nativi americani come “padri fondatori“, e un George Washington di pelle scura. La destra americana ha criticato tali errori, sostenendo che evidenziano i pregiudizi delle big tech contro i bianchi.

Il caso evidenzia le limitazioni dell’attuale intelligenza artificiale generativa. Gary Marcus, professore emerito di psicologia alla New York University, ha dichiarato che potrebbe trattarsi semplicemente di un “software scadente“.

Gemini Pro 1.5, un importante aggiornamento presentato la scorsa settimana da Google, ha introdotto funzionalità avanzate, ma le rappresentazioni imprecise hanno sollevato dubbi sulla vera intelligenza del sistema. Jack Krawczyk, direttore per la gestione dei prodotti di Gemini Experiences, ha ammesso che il modello “sta mancando il bersaglio” e ha assicurato che stanno lavorando per migliorare le rappresentazioni.

Equilibrio tra rappresentazione e Intelligenza Artificiale

Le critiche sono cresciute online, con accuse di “razzismo” e insinuazioni di essere influenzati dal “virus della mente woke“. Esperti sottolineano che il problema risiede nella limitata intelligenza dei modelli di intelligenza artificiale generativa, non in un presunto atteggiamento politico di Google.

Sasha Luccioni, ricercatore presso Hugging Face, una startup di AI, ha evidenziato il difficile equilibrio tra rappresentazione e diversità nei modelli AI. Afferma che “i pregiudizi sono davvero uno spettro”, sottolineando la complessità della sfumatura nel contesto storico.

In un settore in rapida crescita, il caso di Gemini riflette la sfida di calibrare modelli AI per evitare pregiudizi senza perdere rappresentatività. Luccioni commenta che non esiste una risposta unica e che le aziende adottano approcci diversi. Sembrerebbe che Google, con Gemini, stia ancora cercando il giusto equilibrio.