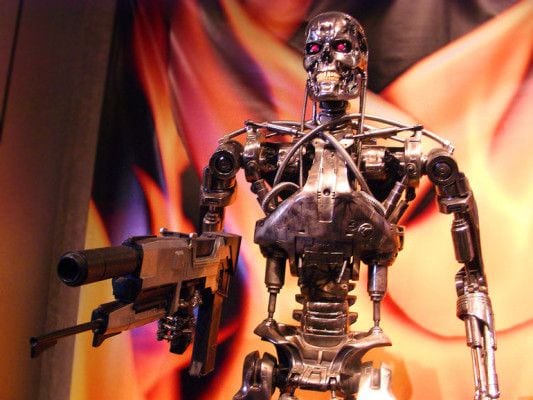

Evitare lo sviluppo dei robot-killer sul nascere. Una decisione in controtendenza con la pubblicazione del documento sui principi della ricerca sull’Intelligenza Artificiale. Oggi, il Future of Life Institute focalizza la propria attenzione sui rischi derivanti dall’uso (ma, forse, soprattutto, abuso) della IA legata agli armamenti. In particolare, ci si riferisce alle armi autonome, ovvero i robot-killer appunto, i quali non vanno assolutamente sviluppati.

Un documento firmato il 27 luglio, in occasione della Conferenza internazionale comune sulla Intelligenza Artificiale a Buenos Aires, da oltre un migliaio tra esperti, ricercatori, scienziati e membri della comunità tecnologica internazionale. Nomi ben noti, come quelli di Elon Musk, Stephen Hawking, Steve Wozniak, Noam Chomsky ed altri ancora. Tutto nasce dalla consapevolezza (e dalla paura) da parte del FLI che, in tempi relativamente brevi, di armi automatiche in grado non solo di sparare ma, soprattutto di decidere quando farlo, possano esserne sviluppate in numero spaventosamente alto. Un progresso reso possibile, purtroppo, dagli avanzamenti nella ricerca sull’Intelligenza Artificiale e che potrebbero impattare probabilmente sullo sviluppo più significativo delle armi nucleari. Lo stesso Hawking ha affermato che l’IA potrebbe tradursi nella caduta della razza umana, mentre la logica di cui sarebbe in possesso potrebbe rapidamente evolversi oltre la nostra capacità di controllarlo.

Quello che si dovrebbe evitare è la “corsa agli armamenti autonomi“, con la quale i governi più ricchi e quelli più bellicosi siano in grado di far progredire lo sviluppo dei robot-killer. Una capacità che potrebbe favorire le disponibilità di terroristi e criminali, con un facile accesso al mercato nero. E il bilancio delle vittime sarebbe catastrofico. Un documento che “sfida” le superpotenze militari, come gli Stati Uniti, la Russia e la Cina, a fare accordi di politica internazionale contro l’uso dell’IA come arma sul campo di battaglia.

I ricercatori impegnati nella ricerca sulla IA, dal canto loro, non hanno alcun interesse a sviluppare armi “intelligenti”. E, allo stesso modo, i chimici e i biologi non vogliono creare armi chimiche o biologiche. “Le armi autonome sono l’ideale per attività come omicidi, destabilizzazione delle nazioni, sottomissione delle popolazioni ed estinzione selettiva di un particolare gruppo etnico“, si legge nel documento. “A differenza delle armi nucleari, l’IA non richiede materie prime costose o difficili da ottenere, in tal modo potrebbero diventare onnipresenti ed economiche da produrre per le potenze militari“.

I timori sono legati alla possibilità ipotetica che lo sfruttamento possa scatenare una catena di restrizioni sulla ricerca dell’IA. Oggi, l’Intelligenza Artificiale è ben più “visibile” nelle tecnologie emergenti, come l’auto senza conducente, gli aerei ed altri veicoli. Tuttavia, il suo sviluppo sta lentamente diffondendosi nel settore sanitario, della finanza e della comunicazione.